Introdução

No universo da inteligência artificial (IA), duas tecnologias têm se destacado por seu enorme impacto e potencial transformador: Machine Learning (ML) e Large Language Models (LLMs). Ambos são fundamentais para a evolução da IA moderna, mas operam de maneiras distintas e desempenham papéis diferentes. Machine Learning é um campo da IA que envolve algoritmos capazes de aprender com dados e realizar tarefas sem a necessidade de programação explícita, enquanto Large Language Models, como o GPT-3, são modelos de aprendizado de máquina especializados em entender e gerar linguagem natural.

A crescente presença de LLMs e ML em diversos setores, como saúde, negócios, educação e entretenimento, evidencia a importância de compreender suas diferenças e semelhanças. No campo da saúde, por exemplo, ML é usado para diagnosticar doenças e prever tratamentos, enquanto LLMs podem ajudar a gerar recomendações ou realizar triagens através de interações em linguagem natural. No mundo dos negócios, essas tecnologias estão reformulando processos, desde a análise de grandes volumes de dados até o atendimento automatizado ao cliente.

Este artigo tem como objetivo explorar, de forma clara e acessível, as principais distinções e interseções entre LLMs e Machine Learning. Vamos analisar como essas tecnologias se complementam, seus diferentes usos e o impacto que elas estão gerando no cotidiano. Ao final, o leitor terá uma compreensão mais profunda de como essas tecnologias funcionam e como podem ser aplicadas de maneira eficiente em diversas áreas.

O Que é Machine Learning (ML)?

Machine Learning (ML), ou aprendizado de máquina, é um campo da inteligência artificial (IA) que envolve a criação de algoritmos capazes de aprender com dados e fazer previsões ou classificações sem a necessidade de programação explícita. Ao invés de serem programados com regras rígidas, os modelos de ML são treinados a partir de grandes volumes de dados, permitindo que eles identifiquem padrões e tomem decisões baseadas em exemplos. Em outras palavras, em vez de ser ensinado como fazer uma tarefa específica, o algoritmo “aprende” a realizar essa tarefa por meio da análise de dados passados.

Existem diferentes tipos de aprendizado de máquina, cada um adequado a diferentes situações e tipos de dados. O aprendizado supervisionado é um dos mais comuns. Nesse tipo de modelo, os dados utilizados para treinamento são rotulados, ou seja, cada entrada do conjunto de dados já possui a resposta correta associada a ela. Um exemplo clássico desse tipo de aprendizado é a classificação de e-mails como spam ou não-spam. O modelo aprende a partir de e-mails já classificados e, com isso, consegue identificar novos e-mails como sendo spam ou não, com base em características previamente aprendidas.

Já o aprendizado não supervisionado trabalha com dados que não possuem rótulos. Ou seja, o modelo precisa identificar padrões ou estruturas ocultas nesses dados por conta própria. Um exemplo desse tipo de aprendizado é a segmentação de clientes em um comércio. O algoritmo pode encontrar grupos de consumidores com comportamentos similares sem precisar de uma classificação prévia, ajudando as empresas a entender melhor seus públicos e personalizar ofertas.

Por fim, temos o aprendizado por reforço, no qual o modelo aprende por meio de um sistema de recompensas e punições, semelhante a como os humanos e animais aprendem comportamentos. Esse tipo de aprendizado é comum em jogos e robótica. Por exemplo, em jogos como xadrez ou Go, o modelo aprende qual ação tomar para maximizar a recompensa (ganhar o jogo) e evita as ações que levam à punição (perder o jogo).

O Machine Learning é amplamente utilizado em diversas áreas. Em reconhecimento de imagens, por exemplo, algoritmos de ML são empregados para identificar objetos ou padrões em imagens, como no caso de sistemas de vigilância que detectam intrusos ou em aplicativos de reconhecimento facial. Outra aplicação popular é nos sistemas de recomendação, como os usados pelo Netflix ou Spotify, que sugerem filmes, músicas ou produtos com base nos gostos e comportamentos anteriores dos usuários. Além disso, ML também é utilizado na detecção de fraudes, como no monitoramento de transações financeiras para identificar comportamentos suspeitos e prevenir fraudes.

Em resumo, Machine Learning é uma tecnologia central que está transformando diversos setores, permitindo a análise de grandes volumes de dados e a tomada de decisões automatizadas e inteligentes, de forma mais eficiente e precisa do que seria possível por métodos tradicionais.

O Que é um Large Language Model (LLM)?

Os Large Language Models (LLMs), ou Modelos de Linguagem de Grande Escala, são uma subcategoria de modelos de aprendizado de máquina, com um foco específico em entender e gerar linguagem natural. Enquanto o aprendizado de máquina (Machine Learning) pode ser aplicado a uma variedade de dados (como imagens, vídeos e áudios), os LLMs se especializam no processamento de texto e na geração de respostas baseadas em linguagem humana. Essa especialização os torna particularmente valiosos em tarefas que envolvem interação textual, como chatbots, assistentes virtuais, tradução automática e criação de conteúdo.

O funcionamento dos LLMs é baseado em um processo de treinamento com grandes volumes de dados textuais. Esses modelos são alimentados com quantidades massivas de texto proveniente de diversas fontes, como livros, sites, artigos científicos e outros conteúdos disponíveis na internet. Durante o treinamento, o modelo aprende a identificar padrões na linguagem, como gramática, vocabulário e estrutura de frases, o que lhe permite não apenas entender, mas também gerar texto de maneira que seja contextualmente relevante. A chave para o sucesso dos LLMs é sua capacidade de capturar nuances da linguagem e responder com coerência e fluência, muitas vezes em tempo real.

Entre os exemplos mais conhecidos de LLMs estão o ChatGPT, baseado na arquitetura GPT (Generative Pre-trained Transformer), o GPT-3, uma versão mais avançada dessa tecnologia, o BERT (Bidirectional Encoder Representations from Transformers), desenvolvido pelo Google, e o T5 (Text-to-Text Transfer Transformer), que também se destaca por sua flexibilidade em diversas tarefas de linguagem. Cada um desses modelos tem suas particularidades e foi desenvolvido para aplicações específicas, como geração de texto, compreensão de contexto ou tradução de idiomas. O ChatGPT, por exemplo, é amplamente utilizado em assistentes virtuais e plataformas de comunicação automatizada, enquanto o BERT é comumente empregado em tarefas de compreensão de texto, como buscas e extração de informações.

Embora os LLMs sejam uma especialização dentro do campo do aprendizado de máquina, eles se distinguem de outros modelos de ML principalmente pelo seu foco na linguagem natural. Enquanto o aprendizado de máquina tradicional pode lidar com uma variedade de tarefas (como classificação de imagens ou predição de dados numéricos), os LLMs são otimizados para processar texto em larga escala, captar contextos semânticos e gerar respostas relevantes e coerentes. Essa especialização permite que os LLMs se destaquem em atividades que exigem uma compreensão profunda da linguagem humana, algo que outros modelos de aprendizado de máquina não são projetados para fazer com a mesma precisão e complexidade.

Principais Diferenças Entre LLMs e Machine Learning

Embora LLMs (Large Language Models) sejam uma aplicação específica dentro do campo mais amplo de Machine Learning (ML), existem diferenças significativas entre eles em termos de objetivo, estrutura e capacidade de generalização.

Objetivo e Escopo

O primeiro ponto de distinção entre LLMs e Machine Learning está no escopo e objetivo de cada tecnologia. O Machine Learning é um campo abrangente da inteligência artificial que lida com uma vasta gama de tarefas, como classificação de imagens, reconhecimento de voz, previsão de séries temporais, entre outras. Ele é capaz de trabalhar com diferentes tipos de dados, sejam numéricos, textuais ou até mesmo imagens e áudios. O escopo do ML, portanto, é vasto e pode ser aplicado a muitas áreas diferentes, sempre com o objetivo de identificar padrões e fazer previsões baseadas em dados.

Já os LLMs são modelos de Machine Learning especializados na compreensão e geração de linguagem natural. Eles são um subconjunto de ML focado em trabalhar com texto, ou seja, o LLM é treinado para entender e gerar linguagem humana, o que o torna extremamente eficaz para tarefas que envolvem comunicação escrita, como chatbots, tradutores automáticos ou assistentes virtuais. Portanto, enquanto o ML pode lidar com uma variedade de dados e tarefas, os LLMs se concentram exclusivamente no processamento de linguagem natural.

Estrutura e Arquitetura

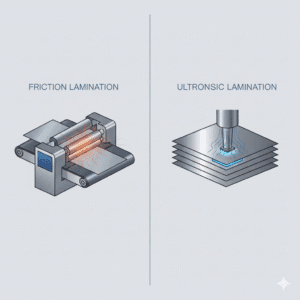

A estrutura e arquitetura de Machine Learning e LLMs também diferem consideravelmente. Modelos tradicionais de Machine Learning utilizam diversas técnicas e algoritmos para resolver problemas. Entre as mais comuns, encontramos redes neurais, árvores de decisão, Support Vector Machines (SVMs) e outros métodos, que são usados para tratar uma ampla gama de problemas, desde a classificação de dados até a previsão de eventos.

Por outro lado, os LLMs são predominantemente construídos com redes neurais profundas (deep learning), que são mais complexas e poderosas. Especificamente, a arquitetura mais comum em LLMs é a arquitetura transformer, como a utilizada pelo modelo GPT-3. Essa arquitetura permite que o modelo lide com grandes quantidades de dados de texto e capture dependências de longo alcance entre as palavras, algo fundamental para a construção de respostas contextualizadas e coerentes. Em resumo, enquanto os modelos tradicionais de Machine Learning podem ser baseados em uma variedade de abordagens, os LLMs dependem fortemente de redes neurais profundas especializadas em linguagem.

Capacidade de Generalização

A capacidade de generalização é outro aspecto importante que diferencia os dois tipos de modelos. Em Machine Learning, a generalização depende muito de como os dados são apresentados e processados durante o treinamento. Modelos de ML podem ser mais específicos em suas tarefas, como identificar padrões em conjuntos de dados estruturados ou classificar imagens, e sua capacidade de generalizar depende da diversidade e qualidade dos dados usados no treinamento.

Por outro lado, os LLMs possuem uma capacidade notável de generalização devido ao vasto volume de dados textuais com os quais são treinados. Um único modelo de LLM, como o GPT-3, pode ser usado para gerar texto relevante em uma variedade de contextos sem a necessidade de ajustes específicos para cada tipo de tarefa. Isso acontece porque os LLMs são projetados para capturar e entender as nuances da linguagem natural e podem ser aplicados a diferentes situações, como responder perguntas, escrever ensaios ou criar diálogos, mantendo a coerência e relevância no texto gerado. A capacidade de generalizar em múltiplos contextos é uma das maiores vantagens dos LLMs, especialmente quando comparados aos modelos tradicionais de ML, que tendem a ser mais especializados.

Essas diferenças e semelhanças destacam como os LLMs se inserem como uma especialização dentro do vasto universo do Machine Learning, focando na manipulação de linguagem natural de maneira extremamente avançada, enquanto o Machine Learning mantém sua flexibilidade e capacidade de lidar com múltiplos tipos de dados e problemas.

Semelhanças Entre LLMs e Machine Learning

Embora LLMs (Large Language Models) e Machine Learning (ML) sejam tecnologias distintas, elas compartilham várias características fundamentais que as unem no campo da inteligência artificial. Uma das semelhanças mais notáveis é que ambos os modelos são baseados no aprendizado a partir de grandes volumes de dados. Tanto os modelos de ML quanto os LLMs são treinados para identificar padrões e fazer previsões ou gerar respostas, dependendo dos dados que recebem durante o treinamento. Essa capacidade de aprender a partir dos dados é o que permite que essas tecnologias desempenhem funções tão poderosas, seja na classificação de informações, seja na criação de texto ou imagens.

Além disso, tanto LLMs quanto muitos modelos de Machine Learning fazem uso de redes neurais, que são sistemas inspirados no funcionamento do cérebro humano. As redes neurais profundas, que são a base dos LLMs, são especialmente eficazes em lidar com dados complexos e em realizar tarefas como o processamento de linguagem natural. Já os modelos de ML, embora mais variados em termos de arquitetura, também utilizam redes neurais para resolver problemas complexos, como reconhecimento de padrões em imagens, previsão de tendências em dados financeiros e muito mais. Essa utilização de redes neurais é um ponto comum que conecta os dois campos da IA.

Outra semelhança importante é que ambos os tipos de tecnologia são fundamentais para o avanço da inteligência artificial. No entanto, enquanto o ML tem um escopo mais amplo, aplicando-se a diversas áreas, como reconhecimento de fala, visão computacional e análise preditiva, os LLMs são especializados no processamento e geração de linguagem natural. Isso torna os LLMs uma aplicação específica dentro do vasto universo de Machine Learning, mas com um foco poderoso em criar interações mais naturais e precisas entre humanos e máquinas.

Por fim, tanto os modelos de ML quanto os LLMs dependem de grandes volumes de dados para atingir um alto desempenho. Quanto mais dados esses sistemas recebem, mais precisos e eficientes se tornam. No caso dos LLMs, isso significa que eles são treinados com imensas quantidades de texto para aprender nuances da linguagem e gerar respostas relevantes. No ML, o treinamento também depende de dados em grande escala, seja para prever comportamentos de consumidores, detectar fraudes ou realizar diagnósticos médicos. Sem dados suficientes, esses modelos não seriam capazes de aprender de forma eficaz e produzir os resultados desejados.

Exemplos Práticos: Como LLMs e ML São Usados em Conjunto

Os Large Language Models (LLMs) e o Machine Learning (ML) são duas facetas poderosas da inteligência artificial, e frequentemente trabalham em conjunto para aprimorar as capacidades de sistemas avançados. Enquanto os LLMs são uma especialização dentro do vasto campo do ML, eles se complementam de maneira significativa, oferecendo soluções que vão desde a compreensão de dados até a geração de respostas contextualmente ricas.

Os LLMs podem ser vistos como uma subcategoria do ML, focada especificamente no processamento e na geração de linguagem natural. Embora o ML como um todo seja responsável por uma ampla gama de tarefas, como classificação de dados, reconhecimento de padrões e previsão, os LLMs se concentram em gerar texto coerente, criar diálogos e até mesmo compreender nuances da linguagem humana. Essa especialização permite que os LLMs sejam particularmente eficazes em tarefas que envolvem comunicação verbal ou escrita, ao passo que o ML se aplica de forma mais ampla em diversos domínios, como a detecção de fraudes, análise de imagens e sistemas de recomendação.

Em muitos sistemas de inteligência artificial, as tecnologias de ML e LLMs são usadas de maneira integrada, combinando os pontos fortes de cada abordagem para criar soluções mais robustas e precisas. Um exemplo claro dessa integração pode ser observado em assistentes virtuais como o Siri ou o Google Assistant. Esses assistentes utilizam o ML para identificar a intenção do usuário, analisando palavras-chave, padrões de comportamento e contextos em tempo real. Uma vez identificada a intenção, é o LLM que entra em cena para gerar uma resposta natural e contextualmente apropriada, permitindo que a interação com o assistente seja fluida e compreensível.

Além disso, as tecnologias de ML e LLMs podem ser aplicadas de forma complementar em várias outras ferramentas de IA, como no caso de sistemas de recomendação. O ML é usado para analisar os dados do usuário e prever preferências, enquanto os LLMs podem ser empregados para gerar descrições detalhadas de produtos, sugestões de conteúdo e até mesmo criar diálogos que ajudem os usuários a fazer escolhas mais informadas.

Outra excelente demonstração de como os LLMs podem ser integrados a modelos de ML é vista em aplicações como o DALL-E e o GPT-3. O DALL-E, uma ferramenta de geração de imagens da OpenAI, combina o uso de redes neurais treinadas com ML para entender e gerar imagens baseadas em descrições textuais. Aqui, o ML é responsável por interpretar a solicitação do usuário, enquanto o LLM gerencia a parte textual da interação, gerando uma descrição que seja compreendida e transformada em uma imagem visual. Já o GPT-3, conhecido por sua capacidade de gerar textos a partir de prompts simples, utiliza a potência do LLM para criar respostas e conteúdos ricos, seja para responder perguntas, gerar código ou até criar histórias.

Portanto, a complementaridade entre LLMs e Machine Learning é uma chave essencial para a criação de soluções de IA mais complexas e eficientes, que aproveitam as capacidades de ambos para lidar com uma ampla gama de tarefas, desde a compreensão de dados até a criação de conteúdo dinâmico e relevante.

Desafios e Limitações

O uso de Machine Learning (ML) enfrenta alguns desafios fundamentais que podem afetar a eficácia e a precisão dos modelos. Um dos maiores obstáculos é a necessidade de dados de alta qualidade e bem rotulados. Modelos de ML dependem de grandes volumes de dados para aprender, e a qualidade desses dados é crucial para garantir que o aprendizado seja eficaz. Se os dados contêm erros, vieses ou estão mal etiquetados, isso pode levar a resultados imprecisos. Além disso, o risco de overfitting é uma preocupação constante: quando um modelo de ML é excessivamente ajustado aos dados de treinamento, ele pode se tornar muito específico e perder a capacidade de generalizar para novos dados, resultando em um desempenho ruim em cenários do mundo real. Outro desafio é a explicabilidade limitada dos modelos de ML. Muitos algoritmos, especialmente os mais complexos, funcionam como “caixas pretas”, o que significa que é difícil entender como o modelo chega a suas conclusões, tornando a análise e a confiança nos resultados um pouco mais complicadas.

Por outro lado, os LLMs (Large Language Models), embora poderosos, também enfrentam desafios próprios. Um problema notável é a geração de respostas imprecisas ou alucinações. LLMs são treinados com grandes quantidades de dados textuais da internet e outras fontes, mas isso não garante que as respostas geradas sejam sempre precisas ou confiáveis. Eles podem, por exemplo, criar informações falsas ou apresentar respostas sem base real, o que pode ser problemático, especialmente em contextos críticos, como saúde ou finanças. Além disso, os LLMs exigem uma enorme demanda computacional, o que pode tornar seu uso dispendioso e inacessível para algumas empresas ou usuários. Outra limitação é que os LLMs são limitados pelo treinamento com dados existentes. Isso significa que, embora possam gerar texto com base em padrões que aprenderam, eles não possuem conhecimento real ou capacidade de raciocínio independente; sua habilidade de gerar conteúdo é restrita ao que foi aprendido durante o treinamento.

É importante notar que, embora os LLMs sejam extremamente poderosos na geração de linguagem, eles ainda dependem das fundações do Machine Learning para realizar tarefas específicas, como o reconhecimento de intenção ou a análise de sentimentos. Em outras palavras, enquanto um LLM pode criar textos impressionantes e fluentes, ele ainda precisa do suporte de modelos de ML para entender o contexto de uma conversa, identificar emoções subjacentes ou classificar dados de forma eficaz. Portanto, os desafios e limitações enfrentados por cada tecnologia não são isolados; eles se sobrepõem e muitas vezes se complementam, tornando o desenvolvimento e o uso de LLMs e ML um processo interdependente, onde um ajuda a superar as limitações do outro.

O Futuro dos LLMs e Machine Learning

O futuro do Machine Learning (ML) é promissor, com uma série de avanços e inovações moldando o caminho dessa tecnologia. Técnicas como aprendizado por reforço, aprendizado federado e ML explicável são algumas das abordagens que estão ganhando destaque. O aprendizado por reforço tem sido utilizado para otimizar processos de decisão em sistemas autônomos, como carros autônomos e jogos, onde o modelo aprende com base em recompensas e punições. O aprendizado federado, por sua vez, permite que modelos de ML sejam treinados em dispositivos distribuídos, sem que os dados precisem ser centralizados, o que tem grande potencial para melhorar a privacidade e segurança dos usuários. Já o ML explicável busca tornar os modelos de aprendizado de máquina mais transparentes, permitindo que os resultados gerados sejam compreendidos pelos usuários e, assim, promovendo maior confiança na tecnologia. Esses avanços estão aprimorando a eficiência e a transparência dos modelos, e tendem a ter um impacto significativo em diversos setores, permitindo um maior controle e compreensão das decisões feitas pela IA.

Por outro lado, os Large Language Models (LLMs) também estão evoluindo rapidamente. Espera-se que, no futuro, esses modelos se tornem ainda mais poderosos, com uma capacidade aprimorada de compreensão contextual. Isso significa que eles serão capazes de entender melhor nuances na linguagem, lidar com perguntas mais complexas e fornecer respostas ainda mais precisas. A integração dos LLMs em aplicações mais amplas, como saúde, finanças e educação, é uma tendência crescente. Por exemplo, na saúde, os LLMs podem ajudar médicos a interpretar exames médicos complexos ou fornecer suporte na formulação de diagnósticos. No setor financeiro, podem ser usados para analisar grandes volumes de dados e oferecer insights sobre investimentos e riscos. Já na educação, podem atuar como tutores personalizados, adaptando-se às necessidades de cada aluno e facilitando o aprendizado.

O futuro dos LLMs também pode trazer fusão entre Machine Learning e LLMs. Essa convergência resultaria em novos modelos híbridos que combinam a capacidade generalista do ML com a especialização em linguagem dos LLMs. Tais modelos poderiam ser mais robustos e eficientes, aproveitando o melhor de ambos os mundos. Por exemplo, um modelo híbrido poderia ser usado para analisar dados não estruturados e, ao mesmo tempo, gerar respostas contextualizadas e precisas em linguagem natural. Essa combinação de forças pode resultar em soluções mais avançadas e personalizadas, com a capacidade de resolver problemas mais complexos e em maior escala.

Em resumo, o futuro dos LLMs e do Machine Learning promete ser caracterizado por um aumento significativo em sua eficiência, precisão e capacidade de adaptação. A convergência dessas duas tecnologias, com o tempo, pode levar a avanços revolucionários em uma variedade de campos, tornando a inteligência artificial ainda mais integrada em nossas vidas diárias e em processos de tomada de decisão em diferentes setores.

Conclusão

Em resumo, embora tanto os Large Language Models (LLMs) quanto o Machine Learning (ML) compartilhem a base de aprendizado de dados, suas diferenças são claras em termos de foco e aplicação. O Machine Learning é uma área mais ampla da inteligência artificial, responsável por treinar modelos que podem lidar com diversos tipos de dados, como números, imagens e textos, aplicados a uma variedade de tarefas, como classificação e previsão. Já os LLMs são uma especialização dentro do ML, voltada para o processamento e a geração de linguagem natural, destacando-se na interação com textos e na criação de respostas contextuais e coerentes em diversas plataformas, como chatbots e assistentes virtuais.

Ambos desempenham papéis cruciais no avanço da inteligência artificial, mas com enfoques distintos. O Machine Learning tem uma abrangência maior e pode ser aplicado em diversas áreas, desde sistemas de recomendação até a análise de imagens. Por outro lado, os LLMs se destacam quando o objetivo é trabalhar especificamente com linguagem, seja para tradução, criação de conteúdo ou interação direta com os usuários.

Entender essas diferenças é fundamental para profissionais de IA, desenvolvedores e empresas que buscam adotar essas tecnologias de forma eficaz. Saber quando e como utilizar o Machine Learning ou um LLM pode fazer toda a diferença na escolha da abordagem certa para cada aplicação específica. Esse conhecimento permite otimizar recursos, melhorar a performance dos sistemas e garantir soluções mais adequadas às necessidades de cada setor.

Por fim, convidamos os leitores a explorar ferramentas baseadas em ML e LLMs, como o ChatGPT, para experimentar na prática as capacidades dessas tecnologias. Ao interagir com essas plataformas, é possível perceber de forma tangível as diferenças entre elas, além de explorar todo o potencial que essas ferramentas oferecem para melhorar a produtividade, a criatividade e a tomada de decisões em diversas áreas.